论文名称:Closed-Loop Transcription via Convolutional Sparse Coding

论文全文:https://arxiv.org/pdf/2302.09347

顶会收录:CPAL2024

核心信息:

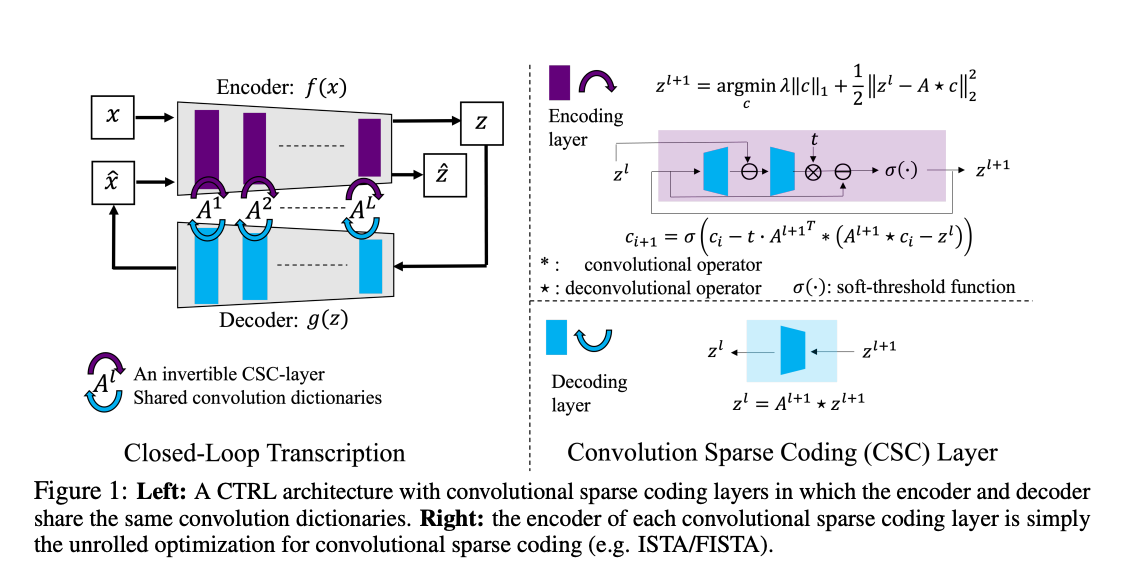

在论文《Closed-Loop Transcription via Convolutional Sparse Coding》中,作者提出了一种新的自动编码器框架,旨在通过卷积稀疏编码(Convolutional Sparse Coding,CSC)实现对自然图像的生成建模。传统的自动编码器通常使用深度网络作为编码器或解码器,这些网络难以解释,且学习到的表示缺乏清晰的结构。为此,作者假设图像分布是由多阶段的稀疏反卷积生成的,对应的逆映射(即编码器)是多阶段的卷积稀疏编码。每个阶段通过展开优化算法来求解相应的稀疏编码问题。

主要内容概述:

背景与动机:

自动编码器的局限性:传统自动编码器使用深度网络作为编码器和解码器,虽然在生成模型中取得了一定成功,但其内部结构难以解释,且学习到的表示缺乏明确的结构。

卷积稀疏编码(CSC):CSC是一种假设图像由稀疏特征和卷积滤波器生成的模型,具有良好的可解释性和理论基础。

目标:结合CSC和自动编码器的优势,提出一种新的框架,实现对自然图像的高效生成和表示学习。

方法:

多阶段稀疏反卷积生成:假设图像是通过多层稀疏反卷积生成的,每一层引入新的稀疏特征和卷积滤波器,以逐步生成复杂的图像结构。

多阶段卷积稀疏编码:对应于生成过程的逆过程,编码器通过多层卷积稀疏编码,将图像分解为稀疏特征表示。

优化策略:为避免直接最小化真实图像与生成图像分布之间的距离所带来的计算困难,作者采用了闭环转录(Closed-Loop Transcription,CTRL)框架,优化学习到的稀疏表示的速率减少(Rate Reduction)。

实验验证:

数据集:在大规模数据集ImageNet-1K上进行实验。

性能比较:在相同条件下,与现有的自动编码器和生成模型相比,所提出的方法表现出竞争力。

资源效率:即使使用更简单的网络结构和更少的计算资源,生成的图像仍具有高质量。

泛化能力:在未见过的数据集上,所提出的自动编码器仍能生成高质量的图像,显示出良好的泛化性能。

优势与贡献:

结构化和可解释的表示:通过引入CSC,学习到的表示具有明确的结构和物理意义,便于理解和分析。

稳定的收敛性:多阶段的设计和闭环优化策略提高了训练过程的稳定性,避免了传统生成模型中常见的不稳定性问题。

可扩展性:该方法能够扩展到大规模数据集,展示了良好的可扩展性。

首创性:这是首次证明多层卷积稀疏编码/解码器的组合可以构建一个可解释且有效的自动编码器,用于大规模自然图像数据集的分布建模。

结论: 作者提出了一种基于卷积稀疏编码的闭环转录框架,为自动编码器的设计提供了新的思路。该方法在理论上结合了CSC的优势,在实践中展示了对大规模自然图像数据集的有效建模能力。未来的研究可以进一步优化该框架,并探索其在其他类型数据和任务中的应用。

参考文献:

Dai, X., Chen, K., Tong, S., Zhang, J., Gao, X., Li, M., Pai, D., Zhai, Y., Yuan, X., Shum, H.-Y., Ni, L. M., & Ma, Y. (2023). Closed-Loop Transcription via Convolutional Sparse Coding. arXiv preprint arXiv:2302.09347. https://arxiv.org/abs/2302.09347