论文名称 MASKED COMPLETION VIA STRUCTURED DIFFUSION WITH WHITE-BOX TRANSFORMERS

全文:https://arxiv.org/pdf/2404.02446

GitHub:https://github.com/Ma-Lab-Berkeley/CRATE

顶会收录:ICLR2024

核心信息:

在论文《Masked Completion via Structured Diffusion with White-Box Transformers》中,作者提出了一种名为CRATE-MAE的深度Transformer架构,用于大规模无监督表示学习。该架构的每一层在数学上是完全可解释的,旨在将数据分布转换为结构化表示,或从结构化表示还原。通过利用扩散、压缩和掩码完成之间的基本联系,CRATE-MAE在大规模图像数据集上展示了出色的性能,同时仅使用了标准掩码自动编码器约30%的参数。此外,CRATE-MAE学习到的表示具有明确的结构和语义意义。

主要内容概述:

研究背景:

无监督表示学习的挑战:现代深度学习框架通常通过在大量未标记数据上训练深度神经网络,解决简单的预训练任务,以学习表示用于下游任务。然而,这些网络的设计通常是经验性的,缺乏可解释性,学习到的表示也缺乏结构性,设计上可能存在冗余。

白盒深度网络的优势:白盒深度网络中,每一层明确识别并转换数据中的结构,提供了一种有前景的替代方案。然而,现有的白盒架构仅在有标签的数据(如分类任务)的监督设置中被证明在大规模上有效。

CRATE-MAE架构:

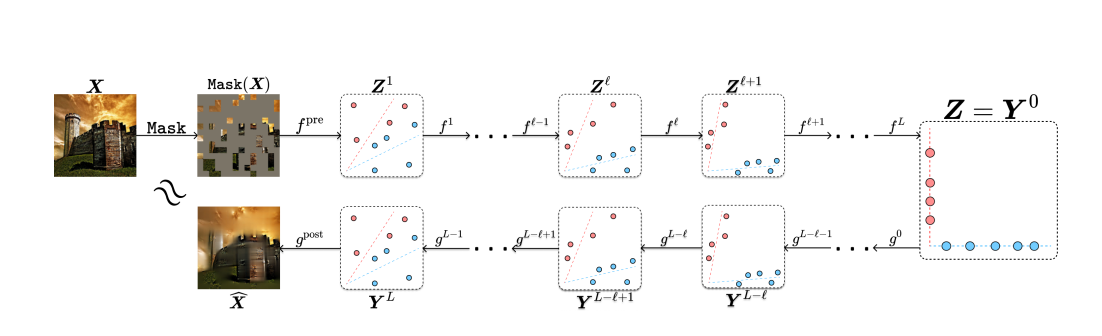

核心思想:通过利用扩散、压缩和掩码完成之间的基本联系,作者推导出一种深度Transformer样式的掩码自动编码器架构,即CRATE-MAE。

架构特点:CRATE-MAE的每一层在数学上是完全可解释的:它们将数据分布转换为结构化表示,或从结构化表示还原。

参数效率:与标准掩码自动编码器相比,CRATE-MAE在相同的模型配置下,仅使用了约30%的参数。

理论基础:

扩散与压缩的联系:作者揭示了去噪扩散模型、压缩和掩码完成之间的定量联系。

结构化表示学习:通过这种联系,CRATE-MAE能够从未标记数据中学习到具有明确结构和语义的表示。

实验验证:

数据集:在大规模图像数据集上进行评估。

性能表现:CRATE-MAE展示了极具前景的性能,同时参数量仅为标准掩码自动编码器的约30%。

表示质量:学习到的表示具有明确的结构和语义意义,有助于下游任务的有效性。

结论: 作者通过揭示去噪扩散模型、压缩和掩码完成之间的基本联系,提出了CRATE-MAE架构,实现了大规模无监督表示学习的白盒设计。该架构在保持高性能的同时,显著减少了参数量,并学习到了结构化且语义丰富的表示,为未来的研究和应用提供了新的思路。

参考文献:

Pai, D., Buchanan, S., Wu, Z., Yu, Y., & Ma, Y. (2024). Masked Completion via Structured Diffusion with White-Box Transformers. arXiv preprint arXiv:2404.02446. https://arxiv.org/abs/2404.02446

附注:

该论文的代码和更多信息可在项目主页获取:https://github.com/Ma-Lab-Berkeley/CRATE