论文名称:White-Box Transformers via Sparse Rate Reduction: Compression Is All There Is?

GitHub:https://ma-lab-berkeley.github.io/CRATE/

地址:https://arxiv.org/abs/2311.13110

论文全文:https://arxiv.org/pdf/2311.13110

学术会议收录:NeurIPS 2023, CPAL 2024, ICLR 2024

核心信息:

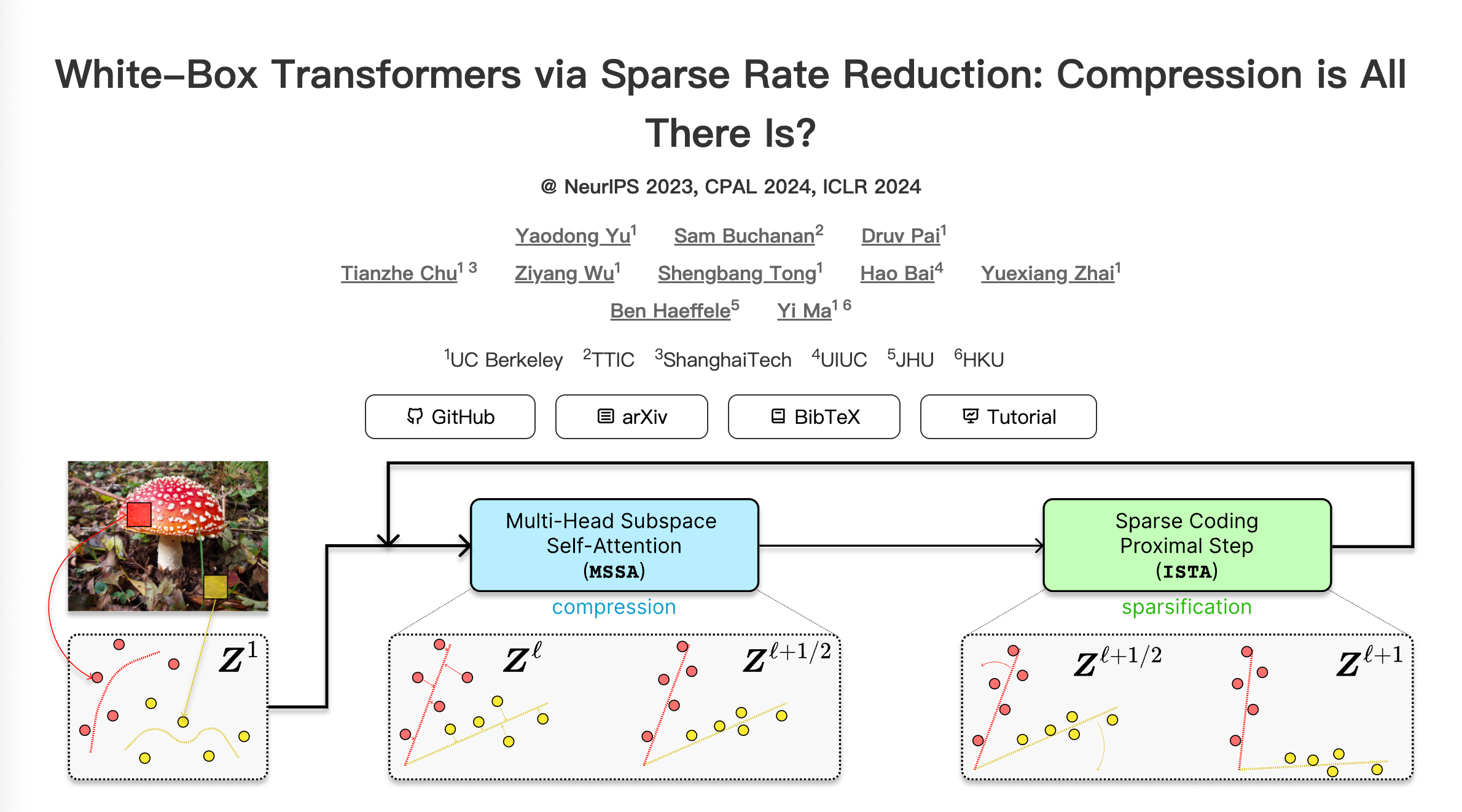

在论文《White-Box Transformers via Sparse Rate Reduction: Compression Is All There Is?》中,作者提出了一种新的表示学习框架,旨在通过压缩和变换数据分布,将其转化为支撑于不相关子空间的低维高斯混合模型。这一框架的核心度量是稀疏率减少(Sparse Rate Reduction),它同时最大化学习表示的内在信息增益和外在稀疏性。从这一角度来看,流行的深度网络架构(如Transformer)可以被视为优化该度量的迭代方案。具体而言,作者从这一目标的交替优化中推导出Transformer模块:多头自注意力机制通过对特征的编码率进行近似梯度下降,实现表示的压缩;随后,多层感知机(MLP)对特征进行稀疏化处理。这引出了一个名为CRATE的白盒Transformer架构家族,其数学上完全可解释。作者还展示了通过去噪与压缩之间的新颖联系,这类CRATE架构可以实现上述压缩编码的逆过程。因此,所推导的白盒架构在编码器和解码器中均具有通用性。实验结果表明,这些网络尽管结构简单,但确实能够学习压缩和稀疏化的大规模真实世界图像和文本数据集的表示,其性能与高度工程化的Transformer模型(如ViT、MAE、DINO、BERT和GPT-2)非常接近。作者认为,所提出的计算框架展示了从数据压缩的统一视角,弥合深度学习理论与实践之间差距的巨大潜力。

相关代码已在https://github.com/white-box-transformer/CRATE 发布。

主要内容概述:

引言:

背景:深度学习模型(如Transformer)在各种任务中表现出色,但其内部机制往往被视为“黑盒”,缺乏可解释性。作者提出了一种新的视角,将表示学习视为压缩和变换数据分布的过程,旨在提高模型的可解释性和性能。

稀疏率减少(Sparse Rate Reduction):

定义:稀疏率减少是一种信息论度量,用于衡量特征空间中子空间状高斯分布之间的距离。

作用:通过最大化这一差异,学习到的表示既包含丰富的信息,又具有稀疏性,有助于提高模型的泛化能力和可解释性。

Transformer的白盒解释:

多头自注意力机制:被视为对特征编码率进行近似梯度下降的步骤,实现表示的压缩。

多层感知机(MLP):用于对特征进行稀疏化处理,增强表示的区分性和稀疏性。

CRATE架构:基于上述理解,作者提出了CRATE架构,其每一层的功能在数学上都是可解释的,体现了白盒模型的设计理念。

去噪与压缩的联系:

理论联系:作者探讨了去噪过程与数据压缩之间的关系,指出通过CRATE架构,可以实现从压缩表示到原始数据的逆变换。

双向通用性:这意味着CRATE架构不仅适用于编码器,也适用于解码器,具有广泛的应用潜力。

实验验证:

图像数据集:在大规模图像数据集上,CRATE模型能够学习到压缩且稀疏的表示,其性能接近于ViT、MAE、DINO等先进模型。

文本数据集:在文本数据集上,CRATE模型的表现也与BERT和GPT-2等主流模型相当,验证了其在不同领域的适用性。

结论:

统一视角:作者提出的框架从数据压缩的角度统一了表示学习的理论和实践,为设计可解释且高效的深度学习模型提供了新的思路。

未来工作:进一步优化CRATE架构,探索其在更多任务和数据集上的应用,以及深入研究去噪与压缩之间的关系。

参考文献:

Yu, Y., Buchanan, S., Pai, D., Chu, T., Wu, Z., Tong, S., Bai, H., Zhai, Y., Haeffele, B. D., & Ma, Y. (2023). White-Box Transformers via Sparse Rate Reduction: Compression Is All There Is?. arXiv preprint arXiv:2311.13110. (arxiv.org)

附注:

该论文已被《Journal of Machine Learning Research》接受,整合了作者之前的工作,并在概念、实证和理论上进行了改进。

相关代码和更多信息可在https://github.com/white-box-transformer/CRATE 获取。